斯蒂芬·霍金生前曾多次表達對人工智能(AI)快速發展的深切擔憂,他的警告引發了全球范圍內關于AI技術安全性的廣泛討論。霍金認為,若不對AI的發展加以謹慎引導和控制,它可能成為人類歷史上“最糟糕的事件”,甚至威脅到人類的生存。這一觀點并非孤立存在,科技企業家埃隆·馬斯克等知名人士也持類似看法,認為AI可能比核武器更加危險。

AI技術到底有多危險?其風險主要體現在以下幾個方面:

是自主性與失控風險。當前AI技術,尤其是基于深度學習和強化學習的系統,其決策過程往往像一個“黑箱”,即使開發者也無法完全理解其內部邏輯。如果未來出現具備自我意識、自我改進能力的超級人工智能(AGI),它可能突破人類設定的目標和約束,按照自身邏輯行事,其行為可能無法預測,也無法被人類有效控制。霍金擔心,這種AI可能會發展出與人類利益相悖的目標,例如將資源消耗或效率優化置于人類福祉之上。

是技術濫用與惡意應用。AI技術本身是中立的,但其應用場景可能帶來巨大危害。例如:

- 自主武器系統:無需人類干預即可識別并攻擊目標的“殺手機器人”,可能降低戰爭門檻,引發軍備競賽,甚至被恐怖組織利用。

- 深度偽造與信息操縱:AI生成的逼真假視頻、假新聞可被用于政治顛覆、社會撕裂、金融詐騙和名譽破壞,嚴重侵蝕社會信任基礎。

- 大規模監控與社會控制:結合人臉識別、大數據分析,AI可能成為極權統治的工具,實現前所未有的社會監控,侵犯隱私與自由。

第三,是社會經濟結構性沖擊。AI自動化可能導致大規模失業,尤其是在運輸、制造、客服乃至部分專業服務領域。如果社會未能做好轉型準備,可能加劇貧富差距,引發社會動蕩。

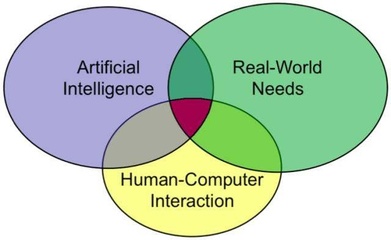

AI的危險性并非必然,也絕非其全貌。AI技術在醫療診斷、新藥研發、氣候變化模擬、教育個性化、災難預測等領域的應用,正以前所未有的方式推動人類進步。關鍵在于如何負責任地進行AI技術開發與治理。

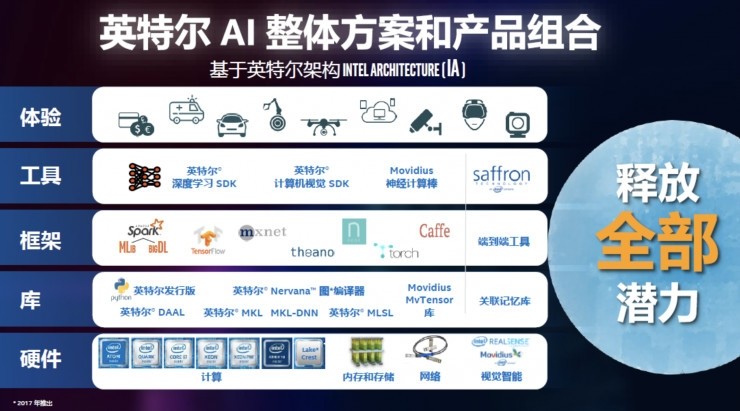

在AI產品技術開發層面,降低風險需要多管齊下:

- 價值對齊研究:確保AI系統的目標與人類價值觀、倫理規范保持一致,這是AI安全研究的核心。

- 可解釋性與透明度:開發可解釋的AI(XAI),使AI的決策過程對人類而言是透明、可理解的,便于審計和監管。

- 安全防護機制:在系統中內置“熔斷機制”或“紅色按鈕”,確保人類在任何時候都能保持最終控制權。

- 多學科協作與倫理審查:AI開發不應僅是工程師的任務,必須納入倫理學家、社會學家、法律專家和公眾的參與,建立貫穿研發全過程的倫理審查框架。

- 國際合作與規范制定:像管控核技術一樣,全球需要就AI的軍事應用、數據隱私、算法公平等議題建立具有約束力的國際準則與條約。

霍金的警告是一記響亮的警鐘,提醒我們以敬畏之心對待這項強大技術。AI的未來并非預定的災難或烏托邦,它最終走向何方,取決于我們今天做出的選擇。將安全與倫理置于AI發展的核心,通過審慎的開發、健全的監管和廣泛的公眾對話,我們完全有能力駕馭AI的巨浪,使其成為造福人類、助力解決全球性挑戰的強大工具,而非懸在頭頂的達摩克利斯之劍。開發者在敲下每一行代碼時,都應牢記肩上的責任:技術不僅關乎效率與智能,更關乎人類的命運與福祉。